統計的パターン認識と判別分析

機械学習の基本タスクである回帰と識別のための様々な手法について,その本質と特性を解説

- 発行年月日

- 2019/01/15

- 判型

- A5

- ページ数

- 236ページ

- ISBN

- 978-4-339-02831-7

- 内容紹介

- まえがき

- 目次

- レビュー

- 広告掲載情報

【読者対象】

機械学習,パターン認識,ニューラルネットなどに興味を持っている学生,研究者

【書籍の特徴】

本書は,パターン認識において用いられる線形回帰や線形判別分析といった手法について,「各手法が本質的になにを実現しようとしているのか」という点を理解するうえで一つの答えを示しています。パターン認識をこれから新たに学びたいと考えている読者はもちろん,各手法をもう少し統一的に理解がしたいと思っている読者にとっても気づきが得られる内容です。

本質的な理解のアプローチとして,機械学習の最も基本的なタスクである回帰と識別について最適な非線形関数がなにかを知り,パターン認識で使われる各手法がその最適な非線形関数をどのように近似しているのかを理解できるような構成となっています。この点はほかの書籍にはみられないアプローチです。

パターン認識をこれから新たに学びたいと考えている読者はもちろん,各手法をもう少し統一的に理解がしたいと思っている読者にとっても気づきが得られるはずです。

【各章について】

各章での説明の流れを簡単に説明します。

はじめの1,2章でベイズ識別の仮定と同様に,訓練サンプルが無限にあり,データの背後の確率的な関係が完全にわかっている場合について,変分法を用いて予測や識別のための最適な非線形関数を導出します。これにより,訓練用のデータ(訓練データ)から学習したモデルが究極的になにを学習しているかを理解します。

(ベイズ識別の理論では,対象の観測値とクラスとの確率的な関係が完全にわかっているという仮定のもとで,識別誤りを最小とする最適な方式が事後確率が最大のクラスの識別方式となることが知られています。)

しかし,実際の応用データでは,データの背後の確率的構造がわかっていることはまれで,それらを訓練データから推定する必要があります。訓練データから確率分布を推定することができれば,推定結果を利用して予測のための最適な非線形関数を近似するモデルを求めることができます。この点について3章で解説しています。

つづく4章では,確率分布の推定を経由せずに,訓練データから直接,入力ベクトルから目的変数の値を推定する関数を構成する手法(線形回帰分析)を解説。さらに5章で,同様にして訓練データから直接,入力ベクトルからクラスを推定する線形識別関数を求める手法として

●2クラス識別のための線形モデル:単純パーセプトロン,ADALINE,ロジスティック回帰,サポートベクトルマシン

●多クラス識別のための線形モデル:最小二乗線形識別関数,多項ロジスティック回帰

●線形識別関数の学習のためのモデルを層状に結合した,多層パーセプトロン

を解説します。

6章では,主成分分析と線形判別分析について,それぞれ手法の特徴と訓練データとの関係に触れたうえで解説を行い,本質的な理解を目指します。

7章では, 特徴ベクトルを非線形に変換することで,その空間で線形モデルを用いて予測や識別を行う手法であるカーネル法について解説します。この方法を用いることでサポートベクトルマシンの認識性能が飛躍的に向上しましたが,本書籍で扱ったほかの多くの線形手法を非線形に拡張する場合にも利用できます。本章ではカーネル回帰,カーネルサポートベクトルマシン,カーネル主成分分析,カーネル判別分析を詳しく採り上げます。

最後の8章では,訓練サンプルが無限にあり,データの背後の確率的な関係がわかっていると仮定して,判別基準を最大とする最適な非線形判別関数を用いて導出する(大津展之先生による手法)。さらに,導出した最適な非線形判別写像と線形判別分析との関係について議論し,カーネル法を別の視点から眺めてみることで,導出した最適な非線形判別分析写像から最適なカーネル関数の導出を行います(判別カーネル)。

【著者からのメッセージ】

パターン認識・機械学習分野の中で「回帰」と「識別」を中心に取り扱う本ですが,従来の類書では詳しく書かれていないであろう式展開なども多く盛り込んでいます。

特に「変分法」や「ベイズ事後確率の線形近似」という道具立てで回帰分析と判別分析の知られざる素性や性質を詳らかにしている部分などをお楽しみ頂ければと思います。

人工知能という言葉がメディアなどでも頻繁に使われるようになり,大量の訓練データから適切なモデルを構築する機械学習が一般にも普及してきています。画像認識などの応用では,深層学習を用いたさまざまな手法が提案され,顔認識などでは人間の能力に迫る認識性能に達しています。

パターン認識は,認識対象がいくつかのクラスに分類できるとき,観測した対象がそれらのクラスのうちのどのクラスのものかを推定する処理であると定義できます。顔認識では,顔の画像からだれかを推定します。もし対象の観測値とクラスとの確率的な関係が完全にわかっていれば,事後確率が最大となるクラスに識別する方式(ベイズ識別)が識別誤りを最小とする最適な識別方式となることが知られています。

機械学習の最も基本的なタスクとして,回帰(regression)と識別(classification)があります。回帰では,訓練データに基づき入力から連続値の出力を予測するための関数を求めます。一方,識別では,対象を計測して得られた入力からどのクラスかを推定する関数を求めます。

本書では,ベイズ識別の仮定と同様に,データの背後の確率的な関係が完全にわかっている場合について,変分法を用いて回帰や識別のための最適な関数を導出します。その結果,回帰のための最適な非線形関数は予測したい値(目的変数)の条件付き期待値となり,識別のための最適な非線形関数が事後確率を要素とするベクトルを出力する関数となることがわかります。このことは,回帰や識別でも,ベイズ識別と同様に,条件付き確率や事後確率が重要な役割を担っていることを示しています。また,回帰や識別のためのさまざまな手法は,条件付き確率や事後確率の有限個の訓練サンプルからの近似を通して,これらの最適な関数を近似的に実現していると解釈できることも示します。

同様に,判別分析についても,データの背後の確率的な関係が完全にわかっている場合について,判別基準を最大とする最適な判別写像を導出します。最適な非線形判別関数においても,事後確率の推定が重要な役割を担っています。線形判別分析は,事後確率の線形近似を通して,この非線形の判別写像を近似的に実現していると解釈できます。

これらの結果の多くは,1980年代に独立行政法人産業技術総合研究所(当時は電子技術総合研究所)名誉リサーチャーの大津展之博士により導出されたものですが,本書では,それらの結果をその導出も含めて整理して紹介します。機械学習のための最適な関数がなにかを知り,有限個の訓練サンプルからどのようにその究極の最適な関数を近似的に実現しているかを理解するというアプローチにより,それぞれの手法の意味をより深く理解できるようになると期待しています。

本書を執筆するにあたって,広島大学大学院工学研究科教授の土肥正氏,および岡村寛之氏からは,多くの助言をいただきました。また,コロナ社の関係各位には,いろいろと配慮していただき,心より感謝申し上げます。

2018年11月 栗田多喜夫,日高章理

1. パターン認識とベイズ決定理論

1.1 パターン認識

1.2 ベイズ決定理論

1.2.1 特徴ベクトルとクラスとの確率的関係

1.2.2 ベイズ決定理論の定式化

1.2.3 0-1損失の場合

1.3 正規分布の場合のベイズ識別

1.3.1 二次識別関数

1.3.2 線形識別関数

1.3.3 テンプレートマッチング

1.3.4 Fisherのアヤメのデータのベイズ識別

2. 最適な回帰と識別

2.1 機械学習

2.2 予測のための最適非線形回帰

2.2.1 平均二乗誤差を最小とする最適な非線形関数の導出

2.2.2 非線形回帰関数fopt(x)の最適性

2.2.3 最適な非線形回帰関数fopt(x)で達成される誤差

2.2.4 最適な非線形回帰関数の統計量

2.3 識別のための最小二乗非線形関数

2.3.1 識別のための非線形関数を構成する方法

2.3.2 識別のための最適な非線形回帰関数で達成される平均二乗誤差

2.4 識別のための非線形識別関数

2.4.1 2クラス識別の場合

2.4.2 Kクラスの場合

3. 確率分布の推定

3.1 確率分布の推定法

3.2 パラメトリックモデルによる確率分布の推定

3.2.1 最尤法

3.2.2 最尤法による確率密度関数の推定の応用

3.3 ノンパラメトリックモデルを用いる方法

3.3.1 ノンパラメトリックな確率密度関数の推定

3.3.2 核関数に基づく方法

3.3.3 K-最近傍法

3.3.4 K-最近傍法による確率分布の推定の応用

3.4 セミパラメトリックな手法

3.4.1 混合分布モデル

3.4.2 混合分布モデルのパラメータの最尤推定

3.4.3 EMアルゴリスム

3.4.4 混合分布モデルによる確率密度関数の推定の応用

4. 予測のための線形モデル

4.1 線形回帰分析

4.1.1 線形回帰分析のモデル

4.1.2 最小二乗法

4.1.3 最適な線形回帰関数flinreg(x)で達成される平均二乗誤差

4.1.4 最適な線形回帰関数の統計量

4.1.5 線形回帰分析の応用

4.2 最適な非線形回帰関数との関係

4.2.1 予測のための最適な線形回帰関数

4.2.2 最適非線形回帰関数の線形近似

4.2.3 条件付き確率の線形近似

4.2.4 条件付き確率の線形近似による最適な非線形回帰関数の近似

4.3 線形モデルを用いた非線形回帰

4.3.1 多項式回帰

4.3.2 基底関数の線形モデルによる回帰

4.3.3 回帰式のカーネル関数による表現

4.4 回帰分析と汎化性能

4.4.1 多項式回帰と汎化性能

4.4.2 モデルの良さの評価

4.5 正則化回帰

4.5.1 リッジ回帰

4.5.2 L1正則化回帰(lasso)

5. 識別のための線形モデル

5.1 線形識別関数とその性質

5.1.1 線形識別関数

5.1.2 線形識別関数の性質

5.1.3 線形分離可能

5.2 単純パーセプトロン

5.2.1 単純パーセプトロンのモデル

5.2.2 単純パーセプトロンの学習

5.2.3 アヤメのデータの単純パーセプトロンでの識別

5.3 Adaptive Linear Neuron(ADALINE)

5.3.1 ADALINEのモデル

5.3.2 ADALINEの学習

5.3.3 回帰分析との関係

5.3.4 正則化ADALINE

5.3.5 アヤメのデータのADALINEでの識別

5.4 ロジスティック回帰

5.4.1 ロジスティック回帰のモデル

5.4.2 ロジスティック回帰のパラメータの学習

5.4.3 Fisher情報行列を用いる学習法

5.4.4 正則化ロジスティック回帰

5.4.5 アヤメのデータのロジスティック回帰での識別

5.5 サポートベクトルマシン

5.5.1 サポートベクトルマシンのモデル

5.5.2 線形分離可能な場合のパラメータの学習

5.5.3 線形分離可能でない場合のパラメータの学習

5.5.4 サポートベクトルマシンとロジスティック回帰

5.5.5 アヤメのデータの線形サポートベクトルマシンでの識別

5.6 多クラス識別のための線形識別関数の学習

5.6.1 多クラス識別のための線形モデル

5.6.2 最小二乗線形識別関数

5.6.3 多項ロジスティック回帰

5.6.4 アヤメのデータの多クラス識別

5.7 識別のための最適な非線形関数との関係

5.7.1 識別のための最適な線形関数

5.7.2 事後確率の線形近似

5.8 多層パーセプトロン

5.8.1 多層パーセプトロンのモデル

5.8.2 多層パーセプトロンの能力

5.8.3 誤差逆伝播学習法

5.8.4 畳込みニューラルネットワーク(CNN)

6. 主成分分析と判別分析

6.1 主成分分析

6.1.1 主成分分析の問題設定

6.1.2 第一主成分の導出

6.1.3 第二主成分の導出

6.1.4 高次の主成分の導出

6.1.5 寄与率と累積寄与率

6.1.6 主成分分析の適用例

6.1.7 元のデータの再構成

6.1.8 主成分スコアベクトル間の距離

6.2 線形判別分析

6.2.1 一次元の判別特徴の抽出

6.2.2 多次元の判別特徴の構成

6.2.3 2段階写像としての判別写像

6.2.4 判別特徴ベクトル間の距離

6.2.5 線形判別分析の適用例

7. カーネル法

7.1 カーネル法とは

7.2 カーネル回帰分析

7.2.1 カーネル回帰分析とは

7.2.2 カーネル法を用いた最小二乗識別関数の学習

7.3 カーネルサポートベクトルマシン

7.3.1 カーネルサポートベクトルマシンとは

7.3.2 最適なハイパーパラメータの探索

7.4 カーネル主成分分析

7.5 カーネル判別分析

7.5.1 カーネル判別分析とは

7.5.2 カーネル判別分析の適用例

8. 最適非線形判別分析と判別カーネル

8.1 最適非線形判別写像

8.1.1 最適非線形判別写像の導出

8.1.2 事後確率ベクトルの線形判別分析

8.1.3 最適非線形判別写像の線形近似

8.2 事後確率の近似を通した非線形判別分析

8.2.1 正規分布を仮定することによる非線形判別分析

8.2.2 K-最近傍法を用いた非線形判別分析

8.2.3 ロジスティック回帰に基づく非線形判別分析

8.2.4 非線形判別空間の比較

8.3 判別カーネル

8.3.1 最適非線形判別分析の双対問題

8.3.2 有効なカーネルの条件

8.3.3 判別カーネルと周辺化カーネルの関係

8.3.4 判別カーネルの族

付録

A.1 線形代数のまとめ

A.2 ベクトル・行列の微分と最適化の基礎

A.3 確率統計の基礎

引用・参考文献

あとがき

索引

@hiro5585様

トラディショナルな統計的パターン認識の手法を一通り述べてあって,入門~中級ぐらいの位置づけかなと思いました。

面白かったなと思ったところは,特徴量と目的変数間に確率的な構造が存在するものとして,どのようなモデル+損失を仮定すれば導けるかを説明していたところです。手法をある程度知っているけれど,さらに踏み込んでどうやってその解が導けるかを詳しく知りたい人に向いている気がしました。

要点をQiitaにまとめています。詳しくはこちらからこ覧ください。

https://qiita.com/hiro5585/items/660f9920896051107304

mat(@ballforest)様

本書の「ご利益」を一言で表せば,回帰と識別(分類)という機械学習における2大タスクの定式化に現れる,(最小二乗誤差の意味で)最適な非線形関数の解釈を通じてこれらをより良く理解することに役立つ,と言えよう。本書では,この最適な非線形関数に現れる事後確率を「線形近似」するアプローチにより,解釈が進められる。実際に,線形回帰/識別関数が,非線形回帰/識別関数の「線形近似」となる事実が,丁寧な導出とともに具体的に示されており,読者は理解を大いに深めることができるだろう。後半の章では,主成分分析/線形判別分析→カーネル主成分分析/カーネル判別分析という流れで話が進み,これらは最終章の布石をなしている。そして最終章において,非線形判別写像に現れる事後確率を線形近似することにより,線形判別分析が導出できる,という事実が示されるのであった。事後確率の近似方法として,正規分布を仮定する場合など線形近似以外の方法についても具体的な言及がされていたのは好印象であった。最適な非線形判別分析をカーネル判別分析として再解釈する議論もまた,読者にとって有益であると思われる。

本書を通読して,確かに対象読者はパターン認識の基礎を「一通り」勉強し,微分積分・線形代数に「十分に慣れた」大学院生や研究者向け,という印象を持った。本書は早い段階で積分を駆使した変分法や確率計算,行列やベクトル計算,行列の偏微分など,高度な数学的操作が現れるため,それらにある程度習熟していることが望ましい。さもなくば,とても「スラスラ」とは読めないであろう。巻末の付録には線形代数,最適化,確率統計の基礎事項がまとめてあり,読者への配慮は伺える。ただし,それらはあくまで備忘録として参照する程度に済むくらいの読者が対象といえるだろう。本書の「まえがき」では付録の存在・活用法について一切言及がないため,ここは幾分残念な点であった。

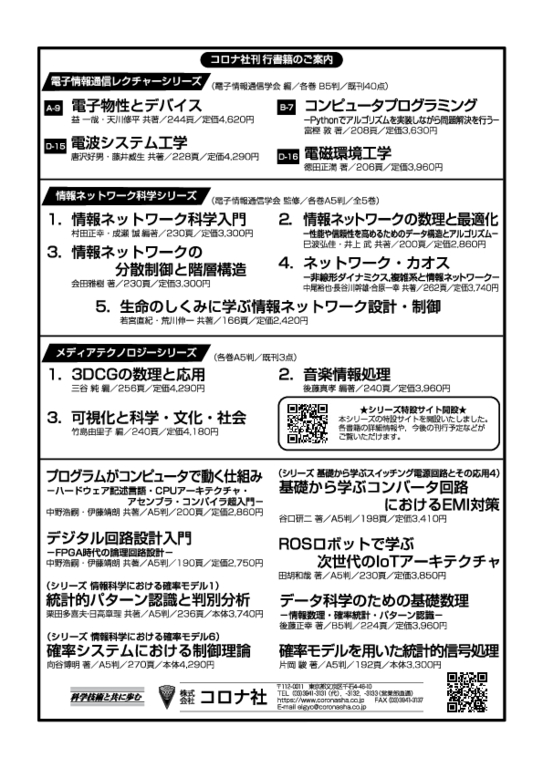

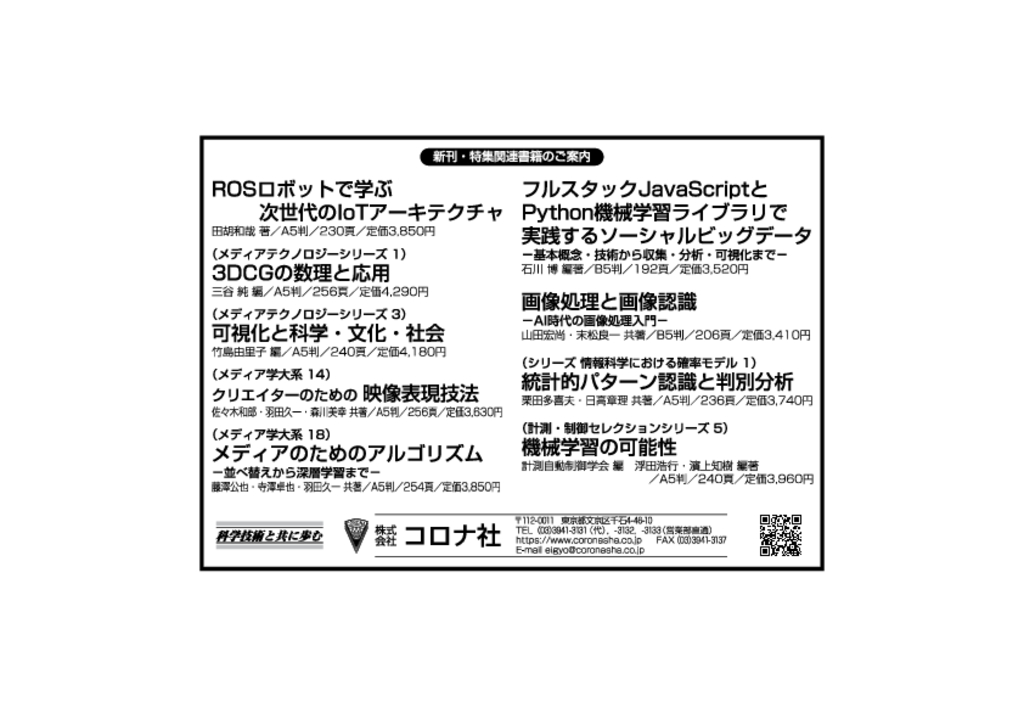

-

掲載日:2024/03/12

-

掲載日:2023/12/04

-

掲載日:2023/07/01

-

掲載日:2023/02/10

-

掲載日:2022/09/05

-

掲載日:2020/06/18

-

掲載日:2020/01/31

-

掲載日:2020/01/29

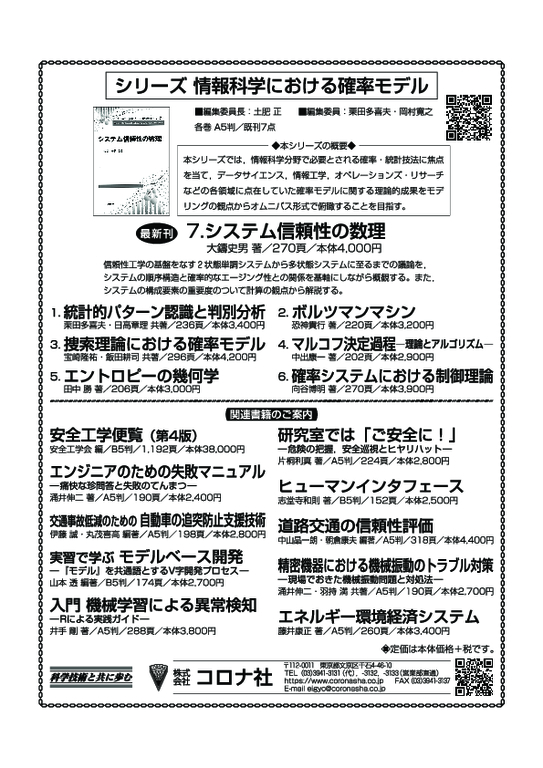

★特設サイトはこちらから★

シリーズ刊行のことば,シリーズラインアップ,著者一覧,書籍の特徴,目次,著者からのメッセージ,キーワードがご覧いただけます